Salutări dragii mei cititori. În acest articol, eu vă va arăta în mod clar cum să facă o robots.txt corectă. că nu a avut nici o eroare care ar putea afecta în mod semnificativ promovarea în motoarele de căutare, cum ar fi Yandex și Google. Să începem în ordine, astfel încât toți ar putea înțelege totul.

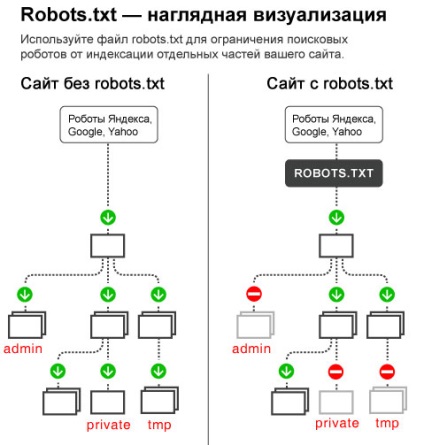

robots.txt - este un simplu note de text la rădăcina site-ului dvs., care definește regulile pentru motorul de căutare boti indexeze și introduceți noul material (pagina) în baza de căutare. În robots.txt vă înregistrați mnozhete, care poate fi indexat pentru site-ul dvs., și ce nu.

Am găsit acest lucru este foarte important să se stabilească de la bun început pentru a crea un blog. pentru că, dacă nu faci toate eforturile tale pot merge la cenușă, iar site-ul dvs. va primi un ban în motoarele de căutare. Dacă se întâmplă acest lucru, atunci se dezvolta site-ul nu va mai face nici un sens, deoarece site-ul de ieșire a interdicției, care, întâmplător, este, de asemenea, numit AGS filtrul va fi foarte dificil. În practică, puțini au putut să se retragă de la site-ul AGS mai puțin de un an.

De asemenea, în plus dublu care urmează să fie închise din index și alte pagini care nu sunt de interes și valoare, atât pentru motoarele de căutare și vizitatorii. De exemplu, administratorul paginii blog unde introduceți numele de utilizator și parola pentru a merge la blog. Cred că nu ești fi foarte încântat dacă o zi văd în tranziția de Statistică, ca cineva care de multe ori vine la tine pe paginile care încearcă să-l sparge și, astfel, fura copilul dumneavoastră.

Ei bine, voi fi bine nu mai sperii, iar apoi probabil ai deja început să se smulgă ochi de frica pe care l-am descris aici ^ _ ^. Doar uita-te la imaginea de mai jos pentru a înțelege mai bine ceea ce face acest fișier.

Cum de a face un robots.txt corect pentru WordPress?

1) Asigurați-vă fișierul pe desktop, care este numit un notebook, și denumiți-o robots.txt. Vreau să observați că unii fac o greșeală prin apelarea fișier robots.txt sau robot.txt. Priviți cu atenție modul în care numele fișierului și apoi roboții de căutare vor pur și simplu ignora, aceasta va conduce în mod inevitabil, după cum am menționat deja la AAC filtru.

2) Acum trebuie să completați în acest fișier, adică, furnizează regulile pentru roboții sunt numite directoare.

1) Primul director, care trebuie să înceapă fișierul robots.txt este user-agent. El răspunde, care executa comanda robotului la un anumit motor de căutare, care va fi descris mai jos. De exemplu, dacă doriți ca această regulă să prescrie pentru toți roboții de căutare, trebuie să adăugați la sfârșitul unei stele.

Dacă doriți să efectuați aceste reguli au aderat la roboții doar de căutare Google, trebuie să vă înregistrați denumirea bot Google în loc de un asterisc.

Exemplu: User-agent: Googlebot

Aici sunt, de altfel, lista numelor roboții motoarelor de căutare populare.

Motoare de căutare. păianjeni motor de căutare.

În cazul nostru, vom prescrie două directoare. Una pentru toate motoarele de căutare și unul pentru Yandex, pentru că el este un foarte capricios și necesită o atenție specială.

2) În robots.txt există două directoare importante. Primul este Allow, care permite bot indexa și Disallow, care interzice indicele. Indiferent că ești robots.txt, trebuie să fie în mod necesar cel puțin un director, spre deosebire de Disallow permite, și apoi robots.txt este greșită.

De fapt, este posibil să nu utilizeze un director Permite, deoarece cu ajutorul directorul Disallow poți nu numai aproape, dar, de asemenea, pentru a deschide robotul de indexare. Uite, dacă ne prescrie acest lucru în directoarele noastre robots.txt, atunci vom permite crawlerului nostru să indexeze întreg blog Yandex.

User-agent: *

Disallow:

Dar dacă pui o liniuță / după Disallow: Interzicem indexul nostru de blog Yandex.

User-agent: *

Disallow: /

Unii webmasteri închide resursa de bot Yahoo, pentru că el are un panou special pe care o puteți arde (a se vedea), link-uri care duc la alte site-uri. Asta este, este posibil să se determine vizual numărul și calitatea de link-uri ar trebui să cumpere pentru a obține aceleași rezultate ca site-ul unui concurent.

Prin urmare, multe prescrise director suplimentare pentru Yahoo, asa ca nu-i indice de viață și, în același timp, nu a tras lorzilor (link-uri), ceea ce duce la site-ul. Dacă prea doriți să închideți indexarea de la Yahoo, apoi scrie în linia următoare robots.txt:

3) Acum trebuie să închidă paginile care se referă direct la motor WordPress.

Disallow: / wp-login.php

Disallow: /wp-register.php

Disallow: / webstat /

Disallow: teme / wp-content /

Disallow: plugins / wp-content /

Disallow: limbi / wp-content /

Disallow: / wp-content / cache

Disallow: / wp-admin /

Disallow: / wp-include /

În folderul wp-conținut nu este nimic valoros cu excepția fotografiilor noastre, care se află în încărcările așa că am prescris separat reguli pentru toate dosarele care sunt în wp-content. Dacă folderul wp-content încă mai aveți folderele care sunt script-uri sau altceva, este mai bine să se uite la nu pentru a arăta că prevede, de asemenea, acest dosar în fișierul robots.txt.

4) Acum, închide paginile care ne dublează.

sitemap.xml - o hartă a site-ului pentru motoarele de căutare, care ajută foarte mult mai rapid pentru a indexa site-ul. Acest card se poate face cu plugin-ul simplu Google sitemap-ul, sau pe acest site. Dacă faci pe mysitemapgenerator.com, după ce a făcut o hartă sitemap.xml va nevoie de ea mai târziu pentru a arunca în rădăcina blogului.

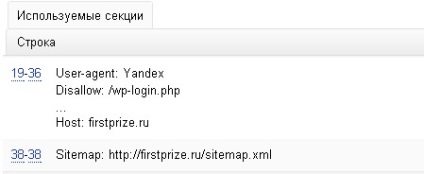

6) Aici este un exemplu de cum să se uite fișierul robots.txt adecvat pentru WordPress. Doar nu-l copiați pentru ei înșiși, așa că atunci am explica doar ceea ce pagina este responsabil pentru ceea ce.

Cum de a verifica erorile robots.txt?

4) După ce ați înregistrat toate directoarele din fișierul robots.txt pe care doriți să-l încărcați la rădăcina site-ului dvs. prin intermediul programului FTP în folderul httpdocs (sau public_html. Www, domenii). Apoi, faceți clic pe link-ul din panoul de Webmaster Yandex și du-te la „Setări de indexare“, „analiza unui robots.txt“. Acum, pur și simplu faceți clic pe „Încărcați robots.txt de pe site-ul“ si apoi „check“. Dacă vedeți următoarele rânduri, atunci aveți robots.txt corect.

Ok, acum aceeași verificare de la Google aici. Du-te la „scanare“ și apoi în „blocat URL-ul“ și apăsați pe „check“. Aici, de asemenea, va oferi informații pentru Google, cum ar fi Yandex, în cazul în care fișierul robots.txt va fi greșeli. Ei bine, există, de exemplu, dacă ai scris Disllow în loc Disallow.

După ce modificați robots.txt setările sale nu au efect imediat, dar când vii din nou bot de căutare și va indexa fișierul din nou, iar apoi va trebui să aștepte un pic mai actualiza SERPs (1-3 luni).

Asta e tot. Dacă aveți în continuare întrebări cu privire la modul de a face o robots.txt corectă pentru WordPress, apoi cereți-le să-mi aici.