- Modul de economisire a energiei este dezactivat

- Ora este GMT + 2

- Toate actualizările instalate prin WSUS instalate

Patru cartele de rețea, câte două pentru fiecare sistem.

Login: ekzorchik (Contul se află în grup - Domain Admins)

Eth0: 10.0.2.19 - rețea externă pentru domeniul polygon.local

Subnet Mask: 255.255.255.0

Eth1: 192.168.117.2 - rețea internă, adică clusterul 1 privește la clusterul 2 și nicăieri altundeva.

Nu există niciun gateway sau DNS.

Eth0: 10.0.2.21 - rețea externă pentru domeniul polygon.local

Subnet Mask: 255.255.255.0

Eth1: 192.168.117.3 - rețea internă, adică clusterul 2 se uită la clusterul 1 și nicăieri altundeva

Subnet Mask: 255.255.255.0

Nu există niciun gateway sau DNS.

Pregătiți gazdele Cluster1 și Cluster2 instalând componenta "FailoverClustering" în ele.

Setările gazdăCluster1

Lansați modulul snap-in pentru a adăuga caracteristica Cluster de refacere

Componenta «Clustering de reluare a sarcinilor»

Trecem prin Next și Install și așteptăm până când componenta este instalată.

Setările gazdăCluster2

Executăm aceleași manipulări ca și cu gazda Cluster2 pentru a instala componenta.

Acum vom conecta discul partajat pentru ambele gazde.

Pentru a câștiga un cluster, avem nevoie de un disc partajat conectat la un Cluster1 sistemele noastre și Cluster2 pentru care folosesc o completare snap integrat «iSCSIInitiator». Cum să configurați conexiunea, am pictat deja, faceți conform instrucțiunilor.

După ce trecem la sistemul Cluster1. apoi deschideți modulul snap-in "Start" - "ControlPanel" - "AdministrativeTools" - "Server Manager" - "

Și vă atragem atenția asupra faptului că avem o unitate conectată prin modulul snap-in iSCSIInitiator:

Acum trebuie să îl traduceți în modul "Online":

Creați un volum (Volum simplu nou ...):

specificați dimensiunea de volum în megaocteți (voi lăsa implicit 2045), și atribui o literă de unitate pentru unitatea logică, de exemplu «Q». specificați un sistem de fișiere (NTFS) și o etichetă de volum (de exemplu, "Quorum").

În continuare trebuie să mergeți la al doilea nod al Cluster2. deschide, de asemenea, elastic de fixare «Start» - «ControlPanel» - «Instrumente de administrare» - «Server Managerul» - «Storage» - «Disk Management» (sistem de management al discului) și pe același principiu ca mai sus va activa discul, marca, dar după traducere la starea "Offline".

Partea pregătitoare este finalizată.

Acum puteți continua să îmbinați nodurile Cluster1 și Cluster2 într-un cluster.

Această procedură este efectuată o singură dată

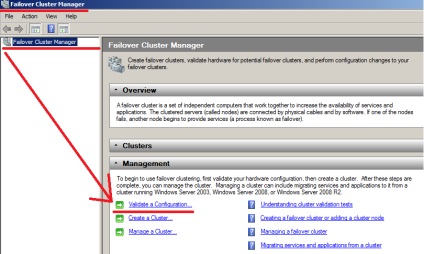

Pentru a face acest lucru, mergem la prima gazdă Cluster1 și deschideți modulul de configurare a modulului Failover Cluster Manager.

În modul snap-in rezultat, ar trebui să rulați Expertul de configurare a validării - "Validatea Configuration ..."

Acum, când componenta este instalată pe ambele gazde, puteți continua să creați grupul.

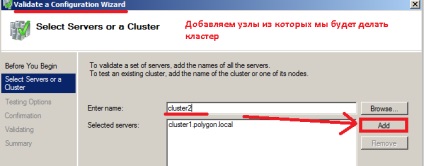

Acum trebuie să selectăm nodurile din care vom face clusterul. pentru conformitate.

Introduceți numele serverului, în cazul meu, Cluster1 și faceți clic pe Adăugați.

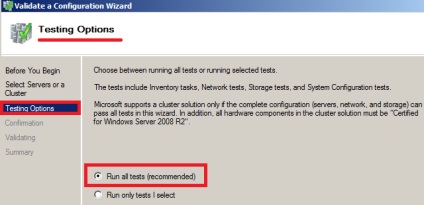

Faceți clic din nou pe Următorul, iar în pasul următor vom marca elementul "Rulați toate testele (recomandat)".

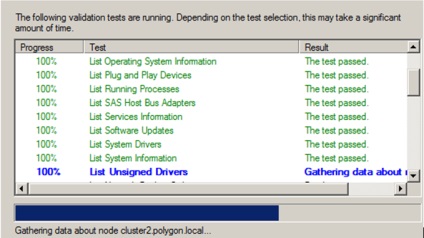

Imaginea de mai jos arată că testele sunt finalizate cu succes și puteți observa, apoi aspectul, apoi dispariția unității comune iSCSI conectate.

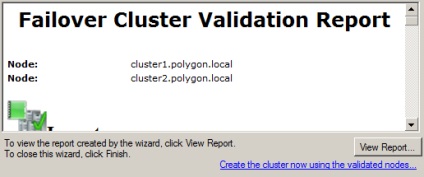

La sfârșitul testelor, vă puteți familiariza cu raportul în care există zone problematice care interferează cu creșterea clusterului:

În cazul meu, totul este bine, fără probleme.

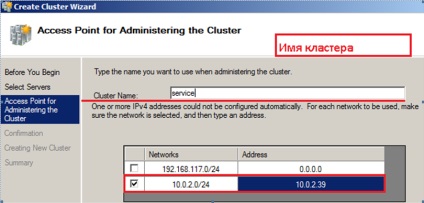

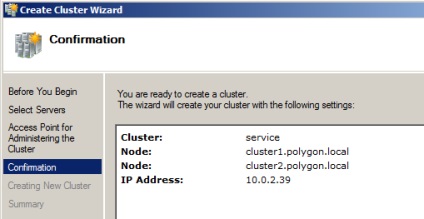

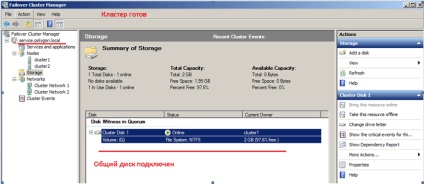

Aceasta completează toți pașii pregătitori, faceți clic pe Următorul. De fapt, instalarea are loc. După terminarea implementării, modulul "Failover Cluster Manager" este vizibil pentru numele grupului, nodurile din care acesta este alcătuit și discul partajat.

Acesta este de fapt întregul proces de ridicare a grupului în condiții de testare. Această notă este un fel de proces pas cu pas de configurare și testare a funcționalității pentru utilizarea deja în sistemul de luptă. Asta e, noroc.