Fișierul robots.txt este originalul și unul dintre cele mai importante instrumente pentru indexarea corectă a site-urilor și a conținutului acestora. Absența acestui dosar va duce la consecințe triste care vor fi greu de corectat. Din modul în care ați configurat robots.txt depinde ce se va obține în emiterea cererilor în motoarele de căutare. Acum, luați în considerare fișierul robots.txt corect pentru site-ul WordPress.

Navigarea pe pagină:

De ce să folosiți robots.txt?

Înainte de a începe să creați și să umpleți, să aruncăm o privire la esența acestui fișier.

Site-ul dvs. este un set de fișiere și foldere, dintre care unele trebuie să fie protejate împotriva citirii de la ochii unor terți, care sunt și roboți de căutare care vin să citească și să-și amintească conținutul, pentru a fi eliberați în continuare în căutare.

Ce face robotul de căutare pe site?

De exemplu, site-ul dvs. a fost vizitat de un robot de căutare, ce face mai întâi? În primul rând, încearcă să găsească informații unice care pot fi introduse în baza sa de date. Dacă Roboți lipsă, și anume se adresează în primul rând robot, atunci el începe să „citească“ fișiere localizate în rădăcina site-ului, care, desigur, noi nu prea place, pentru că el nu numai că nu a găsit acolo informațiile de care are nevoie, dar citi datele noastre setările create pentru scopul nostru personal. De aceea există robots.txt. El dă instrucțiuni robotului unde să meargă și unde să se uite nu merită.

Creați și găzduiți un fișier pe site-ul WordPress.

Pentru a crea un ghid pentru roboți, veți avea nevoie de un obișnuit notepad de ferestre, în care veți aloca comenzile necesare pentru roboții de căutare. După aceea, trebuie să salvați fișierul în format "txt", numit "roboți". Aceasta finalizează crearea, apoi în articol vom lua în considerare ce comenzi ar trebui să fie în robots.txt pentru WordPress.

Unde să locuiți?

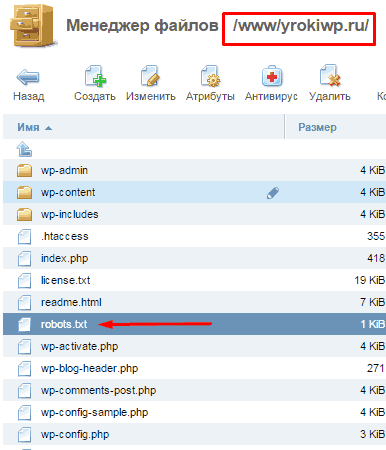

Robots.txt este găzduit pe gazdele dvs., direct în dosarul rădăcină al site-ului în care am mutat site-ul nostru. Acum, robotul de căutare înainte de a urca pe site-ul nostru, cere mai întâi permisiunea acolo unde poate și unde este interzisă plecarea.

Important: când plasați un document în subdirectoare, roboții nu pot găsi acest fișier.

Când vii pe site-ul tău, robotul vine în căutarea "instrucțiunii" destinate pentru el și începe să-l studieze. După ce ați studiat până la sfârșit, veți urma calea de indexare aleasă și veți ignora acele directoare, foldere și adrese URL la care vă este interzis accesul.

Ce includ roboții?

Robots.txt conține date informative pentru roboți de căutare și include astfel de "comenzi" de bază:

Indică numele robotului potențial al vizitatorului. Sintaxa "User-agent: *" va însemna că toți roboții trebuie să urmeze aceste comenzi. Nu vom lua în considerare opțiunile pentru roboți individuali, există o mulțime de ele. Pentru acest exemplu, vor exista doar două opțiuni (pentru toate roboții și separat pentru Yandex).

Această comandă spune robotului ce versiune a site-ului va fi oglinda noastră principală a site-ului.

Locația hărții site-ului xml pe care ne-a vizitat robotul, în partea pentru care a venit (conținutul site-ului).

Pentru a configura corect fișierul robots.txt special pentru "motorul" WordPress, trebuie să înțelegeți mai întâi ce roboți caută și ce vor fi interesați.

Iar păianjenii noștri caută conținutul resurselor noastre și ei absolut nu trebuie să știe despre toate celelalte date de configurare ale site-urilor noastre. În primul rând ei trebuie să nu le place, și de la supraalimentarea cei care părăsesc site-ul nostru și nu a găsi ceea ce ne-am dorit, dar încă va face ochii noștri interzis pentru datele generale privind afișarea publică.

Acum voi arăta versiunea finală. Apoi vom analiza fiecare linie din descrierea extinsă. Deci, robots.txt corect pentru WordPress ar trebui să arate astfel:

Acum, să vedem cum am putea obține un astfel de conținut scurt al fișierului robots.txt pentru WordPress, să luăm în considerare versiunea extinsă a fișierului și să eliminăm treptat repetițiile:

Exemplul de mai sus va bloca toate fișierele și legăturile inutile din indexarea de la indexare și va indica materialul care ar trebui indexat.

Ei bine, avem un exemplu foarte lung, acum o vom simplifica. Mai întâi, să preluăm fișierele și folderele cu prefixul "wp-", toate acestea pot fi combinate.

Reducerea semnificativă, dar aceasta nu este limita, să mergem puțin mai departe și să încercăm să o scurtăm și chiar să facem setările interne necesare.

Lucrul este că, cu această versiune a fișierului, Google va adăuga în continuare paginile pe care le-ați interzis indexului, dar ele vor arăta diferit:

Nu este la fel de periculos ca dublurile deschise, dar e mai bine să scapi de el. Pentru a remedia această situație, puteți utiliza mai multe metode simultan. Vă voi spune despre cel mai rapid și mai simplu mod - interzicerea indexării paginilor utilizând Parametrii URL ai URL-urilor din Instrumentele Google pentru webmasteri. Apropo, în recomandările pentru Yandex, este mai bine să lăsați parametrul "feed" în varianta specificată.

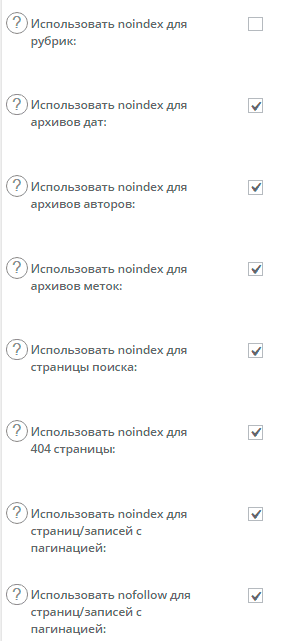

Am scăpat de hrană utilizând Google, este acum o alternativă pentru a preveni indexarea paginare folosind plugin-ul, care este cel mai probabil folosit de tine, dar dacă nu, atunci ca o abordare alternativă. Este vorba despre SEO All-in-One și setările sale pentru etichetele "roboți" și "canonice".

Pentru a interzice indexarea motoarelor de căutare care nu sunt necesare pentru paginile noastre, cum ar fi paginile de paginare de toate tipurile (principale, titluri și etichete), trebuie doar să bifați în locurile potrivite.

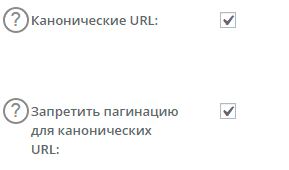

În primul rând, includem legături canonice cu paginile principale, pentru a evita suprapunerea.

Ce am făcut? În general, tot ceea ce era necesar, am indicat în paginile care duplică link-ul nostru de conținut la pagina principală, ceea ce îi va spune robotului exact ce are nevoie pentru a scana și conta pentru conținutul principal. Acum vom adăuga o etichetă meta de roboți.

După ce au fost făcute setările, ne referim din nou la varianta noastră a dosarului și vedem ce se întâmplă:

Dacă tema instalată utilizează imagini, atunci este mai bine să le deschideți pentru index:

Permiteți: / wp-content / themes / numele subiectului / imaginilor

Dacă ignorați acest lucru, este posibil să aveți probleme cu motoarele de căutare, nu le place când ascund informații importante de la ei.

Exemplul poate fi extins, de exemplu prin adăugarea unei interdicții pentru indexarea anumitor linkuri spre pagini, de obicei pagini care duplică optimizarea noastră.

Documentul nu este specificat în mod specific pentru toate roboții de căutare separat, dar fac două seturi de comenzi una pentru toată a doua pentru Yandex.

Google vă recomandă să deschideți toate fișierele de scripturi și stiluri pentru indexare, aceasta nu este preferința mea, ci recomandarea motorului de căutare. Astăzi, bots Google ar trebui să vadă atât site-ul, cât și utilizatorii, astfel că închiderea indexării scripturilor va primi un avertisment atunci când verificați site-ul în Webmasterul Google (Vizualizați ca Googlebot). Un alt lucru de ascuns de la indexarea script-urilor de link-uri în index și nofolks, dar aceasta este o altă poveste)

În ceea ce privește fișierele de instalat. Fișierul robot este conceput pentru a arăta boturile în care conținutul și unde sunt datele tehnice de pe server, din acest motiv tot ceea ce nu suportă sarcina informațională ar trebui închis.

Vă mulțumim pentru clarificare! Totul este clar. Acum se confrunta cu o altă problemă ...

Când introduceți datele de conectare în panoul de control (eu sunt pe hostagator) de hosting, din anumite motive, îmi cere să introduc parola de două ori. Și el spune că prima dată când succes vyshli.Hotya paneli.Stranno am ieșit într-un fel ... atunci du-te la panoul de administrare a văzut unele IP stânga, sub loginom.Probila meu de frunză Blake sa constatat că IP-ul este pe lista neagra din cauza spam. Și asta nu este ip-ul meu. Cum crezi că cineva sa urcat deja în găzduirea mea? Puteți să vă întâlniți cu unul similar? Există vreo sfat despre asta? Voi fi foarte recunoscător pentru acest sfat

Cred că am urcat deja pe site, găzduirea este mai puțin probabilă, deși este posibilă. Dacă a existat o intrare sub login-ul dvs., atunci este necesar să schimbați rapid parola și chiar mai bine și să vă conectați (ștergeți vechea creați una nouă). În ceea ce privește dublu zagovinivaniya, această abordare există, dar dacă a apărut de la sine, ceea ce, desigur, nu este real, atunci site-ul a "lucrat" deja. Aici nu voi da recomandări speciale, trebuie să verific totul și să nu-l amânăm.

Cu HI. Oleg

P / s Sunt "Sunt un ceainic" ...

Disallow: / *? * Nu include Disallow: /? S = *?

vă răspundeți prin e-mail), dar în unele situații trebuie să utilizați numai al doilea, deoarece prima poate afecta indexarea unor pagini, este extrem de rară, dar trebuie să știți acest lucru

De ce avem nevoie de trei reguli?

Nu permiteți: / trackback

Nu permiteți: * / trackback

Dezactivați: * / * / trackback

Nu este suficient unul?

Nu permiteți: * / trackback

Alo Spune-mi răspunsul la următoarea întrebare. Am un site nou, articolele nu au fost încă publicate. Am schimbat prefixul bazei de date cu plug-inul All In One WP Security Firewall. De la site-ul ("zero"), atunci schimbarea în sine a fost nedureroasă.

Întrebarea este după cum urmează. Care este prefixul pe care trebuie să-l scrieți când compuneți fișierul Robots.txt când este specificată directiva Disallow (wp_ sau deja schimbată). În cazul în care apare noua, atunci problema (în avans pare rău pentru o posibilă formulare incorectă) - Ce se întâmplă dacă intimitatea lui, dacă te uiți la ea oricine poate, adăuga în bara de browser după robots.txt slash

Mulțumesc.

Cu Respect.

Baza de date și fișierul robot nu sunt conectate între ele. Fișierele roboților pot fi vizualizate pe orice site, nu sunt secrete, servesc drept ghid și regulă pentru indexarea corectă a site-ului PAGES. În roboți, totul este încă wp-admin ... etc.

Vă mulțumim pentru consultare.