Pagini similare (duplicate). Cum să identificați conținutul duplicat

Mai jos vom analiza câteva opțiuni comune pentru duplicarea conținutului și acum să vorbim despre modul în care paginile similare afectează promovarea site-ului.

Motoarele de căutare au învățat de mult timp să determine unicitatea textului printr-o succesiune de simboluri, adică, în conformitate cu propoziții formulate în mod egal, de unde se ia secvența de litere și spații. Dacă conținutul nu este unic (furat), robotul îl va găsi cu ușurință, iar atunci când nu apare frecvent un text unic, atunci perspectiva obținerii unei astfel de resurse sub filtrul AGS este destul de mare.

Să ne imaginăm munca robotului de căutare. Când accesează site-ul, el se uită mai întâi la fișierul robots.txt și primește instrucțiuni de la el: ce să indice și ce este închis pentru indexare. Următorul pas este accesarea fișierului sitemap.xml, care va arăta robotului harta site-ului cu toate rutele admise. Citiți articolul - "Sitemap.xml pentru motoarele de căutare Google și Yandex". După ce a primit toate informațiile necesare, robotul este trimis pentru a-și îndeplini funcțiile obișnuite.

Să presupunem că o pagină are o unicitate ridicată, iar robotul a indexat-o, dar după ce a ajuns la următoarea adresă URL a aceleiași resurse, ea atinge o pagină cu text complet sau parțial similar. Cum va veni motorul de căutare în această situație? Desigur, și el nu va indexa un test similar, chiar dacă originalul se află pe același site, dar pe o altă adresă URL. Robotul va fi cu siguranță nemulțumit de timpul petrecut inutil și cu siguranță va face o notă mică în carnetul său. Din nou, dacă un astfel de incident apare în mod repetat, resursa poate cădea în defavorizare cu motorul de căutare.

Concluzie nr. 1. Pagini similare aflate pe diferite adrese URL elimină timpul, care este alocat robotului pentru indexarea site-ului. Paginile duplicate el nu va fi indexat, dar va petrece o parte din limita de timp pentru familiarizarea cu ei și probabil că nu va avea timp pentru a ajunge la un conținut cu adevărat unic.

Concluzie nr. 2. Conținutul duplicat va afecta negativ promovarea site-ului în motorul de căutare. Nu-mi plac motoarele de căutare nu sunt texte unice!

Concluzie №3. Este necesar să vă verificați proiectul pe pagini duplicate pentru a evita problemele enumerate mai sus.

Mulți nu-i pasă de "puritatea" conținutului lor. De dragul interesului, am verificat mai multe site-uri și am fost oarecum surprins de starea lucrurilor cu duplicate de pagină. Pe blogul unei femei, nu am găsit deloc un fișier robots.txt.

Este necesar să se lupte serios împotriva duplicatelor de conținut și să se înceapă identificarea acestora.

Exemple de duplicate comune de conținut și modalități de depanare a problemelor

Dublu a paginii principale. exemplu:

În acest caz, problema este rezolvată utilizând 301 redirecționări - o "comandă" pentru server prin fișierul .htaccess. Cum se face o redirecționare 301 (redirecționare) printr-un fișier .htaccess

Un alt exemplu al duplicatului paginii principale:

Pentru a evita o astfel de duplicare, puteți înregistra principala oglindă a site-ului în fișierul robots.txt din directiva - "Host" pentru Yandex:

Și, de asemenea, profitați de 301 redirecționări și îndreptați motoarele de căutare Yandex și Google spre site-ul principal, prin intermediul instrumentelor pentru webmasteri.

Un exemplu de duplicat al paginii principale, care aproape că mi-a explodat creierul atunci când caută o soluție, arată astfel:

Am citit undeva că slash la sfârșitul link-ul de la pagina de start, crearea unei duble și motoare de căutare percep legături cu o bară oblică și nici modul în care diferite URL-ul, ceea ce duce la o pagină cu același text. Nici măcar n-am fost preocupat de posibilitatea duplicării, câtă pierdere în greutate a paginii principale în această situație.

Am început să săpat. La solicitarea serverului de pe adresele URL de mai sus, am primit un cod de răspuns de 200. Codul 200 înseamnă - "Solicitarea utilizatorului a fost procesată cu succes, iar răspunsul serverului conține datele solicitate". Din aceasta rezultă că, la urma urmei, un dublu pe față.

Am încercat chiar să fac 301 redirecționări, dar comenzile nu au funcționat și am primit codul de răspuns dorit 301. Soluția la problemă a fost absența problemei în sine. Pun a primit asta. Se pare că browserele moderne înlocuiesc simbolul "/" la sfârșitul liniei, făcându-l invizibil, ceea ce face în mod automat imposibilitatea dublării. Aici!

Ei bine și încă un exemplu de dublu a paginii principale:

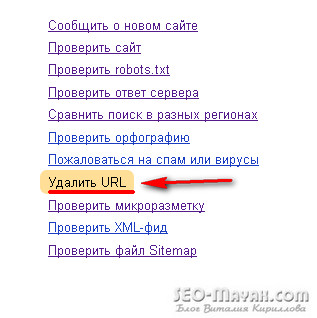

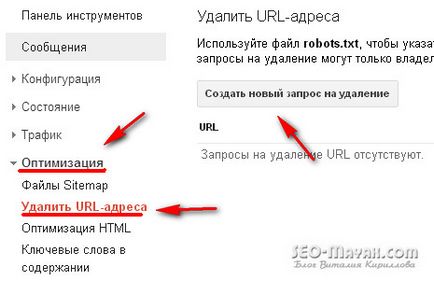

În motorul de căutare Yandex, webmasterul sunt site-urile mele - eliminați adresa URL:

iar în fișierul .htaccess scrieți 301 redirecționări.

Acum treceți prin duplicatele care apar atunci când fișierul robots.txt nu este compilat corect. exemplu:

La prima vedere, nu este nimic special, dar acesta este exemplul clasic de duplicare parțială.

Ce este duplicarea parțială? Aceasta este momentul în care pagina cu anunțuri de posturi intră în index. Dimensiunea acestor anunțuri este aproape jumătate din întregul articol. Nu faceți anunțuri de volum! Soluția la problemă este simplă. În fișierul robots.txt, scrieți următoarele:

Exemplu de duplicare completă:

Soluția este din nou în fișierul robots.txt

Nu vorbesc despre magazinele online și alte site-uri pe o bază comercială, unde situația este diferită. Paginile cu produse care conțin text repetat parțial cu mai multe imagini creează, de asemenea, duplicate, deși totul pare normal. În astfel de cazuri, se utilizează în principal o etichetă specială:

Important! Liniile directoare prevăzute în fișierul robots.txt, interzic roboților de căutare să acceseze cu crawlere textul care proteja site-ul de la dublu, dar aceeași directivă nu interzice URL-ul de index.

Cum să identificați pagini similare dintr-un fragment de text

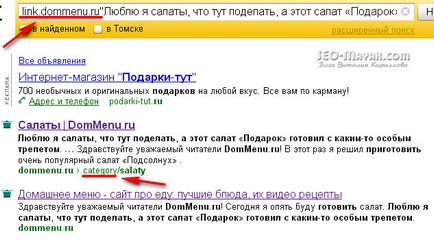

Există o altă modalitate destul de eficientă de a determina "clonele" cu ajutorul motoarelor de căutare propriu-zise. În Yandex, trebuie să faceți ciocan în câmpul de căutare: link.site.com "Fragmentul testului". exemplu:

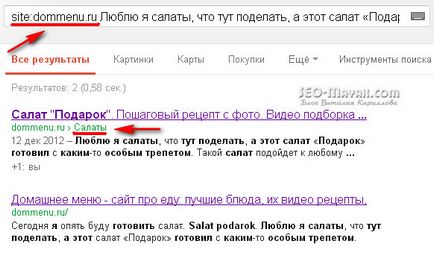

Utilizând căutarea Google, puteți să verificați: site: site.com "Fragmentul textului". exemplu:

Programe și servicii online pentru a căuta duplicate de conținut intern și extern prin fragmente de text

Nu voi face o revizuire detaliată a programelor și serviciilor populare în acest articol, mă voi concentra doar pe cele pe care le folosesc în mod constant.

Pentru a căuta soluții interne și externe, vă sfătuiesc să utilizați serviciul online www.miratools.ru. În plus față de verificarea textului, serviciul include și diverse posibilități interesante.

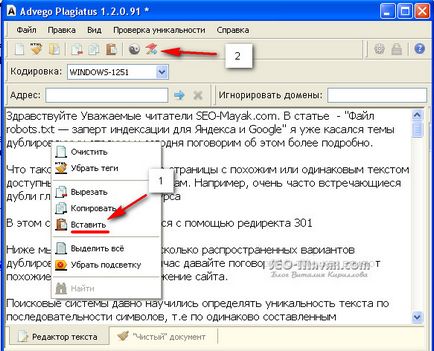

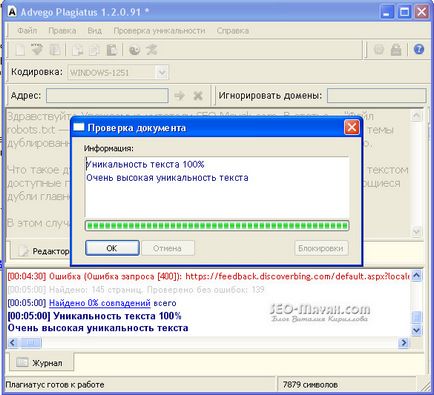

Programul pentru găsirea duplicatelor este Advego Plagiatus. Program foarte popular, eu îl folosesc personal în mod constant. Funcționalitatea programului este simplă, pentru a verifica dacă textul este suficient pentru ao copia și pentru ao lipi în fereastra programului și faceți clic pe start.

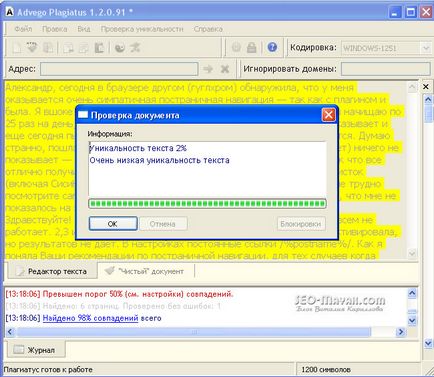

De asemenea, vor fi evidențiate pe fond galben fragmente specifice ale textului, pe care programul a găsit o coincidență:

Program foarte bun, utilizați și asigurați-vă că vă abonați la actualizările blogului.

Pentru ziua de azi, am totul. Mult noroc!

Cu sinceritate, Kirillov Vitaly

Bună ziua! A intrat accidental pe site-ul dvs. și .... paneslas. Deși este încă tânăr, dar am găsit multe lucruri utile pentru mine!

Primul lucru pe care vreau să îl întreb. Este necesar să le atribuiți roboților ca și pentru agentul utilizator: Yandex și pentru agentul utilizator: *.

Și dacă trebuie să prescriu

Dezactivați: / tag /

Dezactivați: / * pagina *

Respingeți: / pagina /

Respingeți: / 20 *

Împiedicați: / categoria /

Vă mulțumim pentru înțelegerea dvs. și așteptăm cu nerăbdare să auzim. Aș aprecia orice ajutor.

Yuri, bucuros să vă urez bun venit pe blogul meu! Da, este necesar să prescrieți totul în mod egal, cu excepția directivei gazdă, este destinat numai pentru Yandex. Yuri, o să explic în ordine. Este necesar să închideți etichetele "Disallow: / tag /" pentru a nu crea duplicate, același lucru se aplică:

Dezactivați: / * pagina *

Respingeți: / pagina /

Respingeți: / 20 *

Împiedicați: / categoria /

Dar este mai bine să folosiți serviciul Webmaster Yandex și să vedeți dacă există duplicate sau pagini non-canonice (identice).

Mult noroc!

Vitaly, ești un om bun! Eu văd articolele cu mare interes.

Vitali, o întrebare despre dublarea paginilor site-ului.

Nu am mage. Dacă am 10 produse cu același nume, care diferă numai în funcție de mărime, cum rămâne cu descrierea mărfurilor, este cu adevărat posibil să scriem o descriere diferită pentru toate cele 10 bucăți?

Valentine, trebuie să arătăm individual aici. Desigur, este mai bine să nu aveți duplicate, dar dacă produsul este același, puteți alege o pagină pentru căutare, iar restul poate fi închis cu eticheta rel = "canonical".

Bună ziua, Tatyana!

Ați făcut totul bine, dar puteți să atribuiți următoarea directivă în fișierul robots.txt:

[php] Disallow: / category / [/ php]

Bună, Vitaly! Va multumim pentru pagina webmasterul poznovatelnuyu statyu.Na Yandex a văzut că multe dintre paginile mele sunt indexate, deși o dată acolo, în webmasteri vă verificați pagina, sistemul oferă răspunsul pe care este permis să-mi indeksatsii.Kak să-l înțeleagă? Trebuie să adaug aceste linii la robot.txt: Disallow: / page /

Respingeți: / 20 *

Împiedicați: / categoria /

Mulțumesc

Buna ziua! Încercați să rearanjați cuvintele și să modificați propozițiile pentru a obține unicitate ridicată. Advego Plagiatus cauta nu numai la alte site-uri, dar, de asemenea, pe dumneavoastră și, prin urmare, se poate compara diferite expresii regulate, care sunt inerente pentru fiecare webmaster, si poate strica bine unicitatea.

Verificați totul, dar unicitatea trebuie să fie ridicată!

Bună, Vitaly! Am mari probleme cu site-ul. Din anumite motive, multe exemplare ale aceluiași articol sunt indexate pe site-ul meu (mai mult de 20). Principalul lucru este că, cu cât mai multe copii devin, cu mai puțin de 100 de posturi scrise în index, Yandex are deja 3000. Ajutor, vă rog! Ce ar putea fi greșit pe site? De ce există atât de multe copii? Astfel de probleme au început să apară după actualizarea pluginului All In One SEO Pack. Am citit articolul dvs. despre configurația plugin-ului - totul este în ordine. În Webmaster-ul Yandex, am descarcat robots.txt. Mi-a dat un răspuns, dar nu am înțeles deloc nimic.

Voi fi foarte recunoscător pentru răspunsul!

Bună Olga! În primul rând nu sunt acoperite de paginare și tag-uri de indexare, eventual altceva. Este greu de spus imediat ce a cauzat apariția unei astfel de legături ca aceasta - Sosna-gornaya-ukrashenie-Sada / 9223372036854775804 /, dar este necesar să se înțeleagă. Deveniți abonat la blog și scrieți-mi prin formularul de feedback. Și vom vorbi cu tine!

Maria, după actualizările Yandex, blogul și-a pierdut poziția de mai multe ori. Cred că acest lucru este legat de reducerea la zero a anumitor factori, deoarece în câteva săptămâni toate articolele "jignite" s-au întors la pozițiile lor anterioare, iar participarea a fost restabilită. Probabil, este logic să așteptați timpul, dar dacă nu se schimbă nimic în două săptămâni, va trebui să bateți alarma. Credeți site-ul pentru duplicate externe și analizați setările de indexare a site-ului. Uitați-vă la câte roboți Yandex au încărcat pagini și câte persoane au fost în căutare și dacă între paginile excluse, non-canonice.

Mulțumesc, Vitaly, o să verific, o să scriu.

Numai azi a fost surprins că atunci când popvtke adaugă un nou articol în addrl-ul Yandex.

Mi-a spus:

Serverul pe care este localizat site-ul nu este disponibil.

Deși site-ul este online. Același lucru și căutarea Google de acolo au zburat toate paginile

Bună ziua Rita! Despre tinctura de indexare a site-ului, am scris mai multe articole.

Meta-tag roboți - Vă sfătuiesc ferm lectură.

Indicele suplimentar

Dacă aveți întrebări, adresați-vă.

Bună, Vitaly!

De mult timp am fost chinuit de întrebarea dacă să deschid arhive pentru indexare, dacă revin periodic articole vechi. Pe acest răspuns, sprijinul Yandex a răspuns: "Dacă astfel de pagini ar trebui să fie indexate și să participe la căutare, interdicția din codul lor sursă ar trebui eliminată. "

Nu prea înțeleg răspunsul. Și întrebarea a fost următoarea: "Am interzis în mod deliberat arhive vechi pentru indexare, dar este corect dacă fac modificări la articole vechi?"

Sper că mă vei ajuta! Mulțumesc!

Tatiana

Bună ziua, Tatyana!

Dacă pagina nu este indexată, modificările nu vor fi indexate.

Tatyana, schimbarea sau adăugarea unei pagini nu a fost pedepsită niciodată, este un proces natural. Un alt lucru este cât de mult aceste schimbări sunt semnificative, testul poate fi complet schimbat sau vor exista unele schimbări mai serioase. În astfel de cazuri, mi se pare dificil să vă dau sfaturi practice.