Un cluster este, în esență, un grup de computere concepute pentru a îndeplini o sarcină specifică. Unul dintre avantajele clusterului este puterea de procesare. Pe un cluster, sarcina va fi executată mult mai repede. Pentru a utiliza puterea de procesare a tuturor computerelor, este necesar un mecanism de schimb de informații. Interfața de mesaje MPI oferă o interfață de programare API bine definită pentru scrierea programelor care folosesc calculul paralel în C sau Fortran.

Structura hardware, software și cluster

- Server OpenPower, model 720

- Un desktop PC

- Red Hat Enterprise Linux 3.0 cu actualizare 3 sau mai mare instalat

- MPI 1.2.7

- IBM XLC 7.0 și XLF 9.1 Compilatoare

Figura 1. Structura clusterului

Instalare și configurare

- Înainte de a începe, verificați următoarele:

- Toate computerele trebuie să aibă instalat Red Hat Enterprise Linux. Pentru instrucțiuni detaliate de instalare, consultați articolul "Linux pe OpenPower: Un ghid de instalare" ("Linux pe OpenPower: Ghid de instalare").

- Pe toate computerele (n1, N2 și n3), utilizatorul hchauhan trebuie înregistrat.

- O coajă securizată (SSH) trebuie să fie configurată pentru utilizatorul hchauhan. De exemplu, utilizatorul hchauhan ar trebui să poată accesa oricare dintre calculatoare fără a trebui să introducă o parolă.

- Trebuie să fie instalate compilatoarele XLC și XLF.

- Arhiva cu codul sursă MPI trebuie dezarhivată într-un director temporar, de exemplu în / tmp.

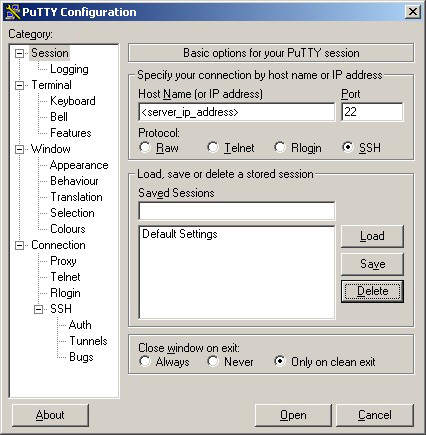

- Pentru a compila și a instala MPI, conectați-vă la computerul n1 de pe PC-ul desktop ca root. Pentru a intra în SSH, utilizați PuTTY.

- Conectați-vă cu succes la PuTTY, puteți continua instalarea:

Listing 1. Linia de comandă PuTTY

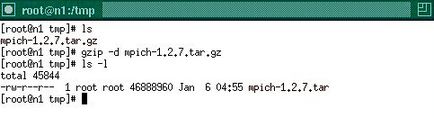

Figura 3. Fișierul mpi-1.2.7.tar

- Dezarhivați fișierul mpi-1.2.7.tar:

Listarea 2. Despachetarea fișierului mpi-1.2.7.tar

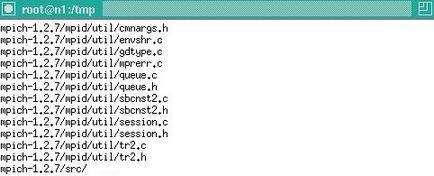

Figura 4. Mesajele de diagnosticare ale programului tar

Figura 5. Director despachetat

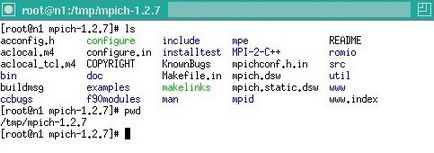

Figura 6. Conținutul directorului dezamorsat

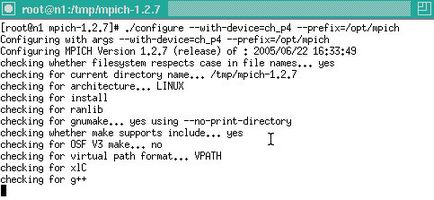

- Rulați scriptul de configurare. care va pregăti un makefile pentru utilitatea de fabricație.

Listarea 3. Scenariul de configurare

Pentru a compila MPI pentru dispozitivul ch_p4, specificați argumentul --with-device = ch_p4. Puteți obține ajutor pentru alte tipuri de dispozitive utilizând comanda ./configure --help.

Scriptul de configurare efectuează o serie de verificări, inclusiv versiunile compilatoarelor instalate, prezența variabilelor de mediu și așa mai departe.

Figura 7. Scenariul de configurare

- Rulați comanda de realizare. care va compila MPI și va pregăti instalarea.

Listing 4. Rularea comenzii de a face

Figura 8. Diagnosticarea mesajelor din comanda de realizare

- Executie face instalare. Pentru a instala MPI în directorul / opt / mpich:

Lista 5. face install

Figura 9. face comanda de instalare

- În acest stadiu, instalarea MPI pe computer (de exemplu, n1) este completă:

Listarea 6. Instalarea a fost terminată cu succes

Figura 10. Instalarea sa încheiat cu succes

- 1. Există două opțiuni pentru acțiuni ulterioare:

- Exportați directorul / opt / mpich și montați-l pe alte computere.

- Repetați pașii de mai sus, compilați și instalați MPI pe toate celelalte computere (n2 și n3).

ATENȚIE: Înainte de a executa următoarele instrucțiuni, asigurați-vă că MPI a fost instalat în directorul / opt / mpich pe toate computerele.

- Editați fișierul / etc / bashrc astfel încât variabila PATH să indice directorul MPI:

Listing 7. Modificarea fișierului / etc / bashrc

- Compilați codul sursă pentru exemple:

Listarea 8. Compilarea exemplelor de cod sursă

- Pentru dispozitive de tipul ch_p4, este necesar un fișier care conține numele tuturor computerelor, de exemplu fișierul nodes.LINUX.

Listing 9. Fișiere nodes.LINUX

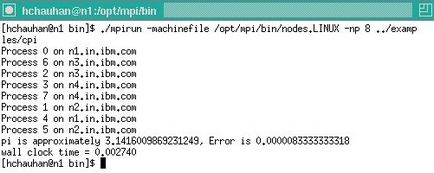

- În numele utilizatorului hchauhan, executați programul demonstrativ cpi sau orice altul:

Listarea 10. Rularea programului demo

Figura 11. Pornirea programului demo

- Mediul MPI este gata de utilizare. Orice program care utilizează apeluri MPI API poate folosi acum puterea de calcul a tuturor computerelor.

Pentru a elimina MPI din sistem, urmați acești pași:

- Rulați scriptul / opt / mpich / sbin / mpiuninstall.

- Rulați comanda #rm -rf / opt / mpich.

developerWorks: Autentificați-vă

Câmpurile obligatorii sunt marcate cu un asterisc (*).

Toate informațiile introduse sunt protejate.

Selectați numele care va fi afișat pe ecran

Câmpurile obligatorii sunt marcate cu un asterisc (*).

Toate informațiile introduse sunt protejate.

Aflați mai multe despre platforma IBM Bluemix, creați aplicații utilizând soluții gata!

Mai mult de trei mii de articole, recenzii, manuale și alte materiale utile.

ArticleTitle = Cluster de înaltă performanță bazat pe MPI: Partea 1. Instalarea și configurarea MPI cu ch_p4 pe serverul OpenPower 720