Este important să oferiți motoarelor de căutare informații reale despre paginile care nu sunt indexate, despre oglinda principală și sitemap-ul (sitemap.xml). Pentru a face acest lucru, fișierul robots.tx este creat în rădăcina site-ului și completat cu directive.

Să luăm în considerare modul în care în cel mai general caz într-un bitrix să creați un fișier robots.txt.

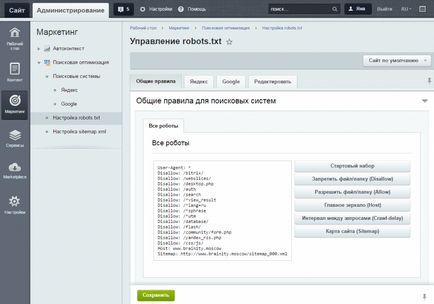

Mai întâi, accesați pagina Desktop -> Marketing -> Search Engine Optimization -> Configure robots.txt

În al doilea rând, indicăm regulile de bază.

În primul rând vedem User-agent: *. acest lucru înseamnă că directivele sunt specificate pentru toate roboții tuturor motoarelor de căutare.

Pentru a închide directorul, scrieți regula:

În al treilea rând, specificăm oglinda principală a site-ului utilizând directiva gazdă. Luați în considerare www, dacă domeniul principal este ales cu www.

În al patrulea rând, în directiva Sitemap vom scrie un link către fișierul sitemap.xml.

În general, acesta este tot ceea ce este necesar, pentru a transfera fișierul webmasterilor Yandex și Google.

De exemplu, nu este necesar să indexați imaginile din directorul / include /, dar doriți ca articolele din această secțiune să fie indexate. Pentru aceasta, ar trebui să închideți directorul / include / pentru robotul YandexImages cu directiva Disallow.

Agent utilizator: YandexImages

Dezactivați: / include /

Distribuie în rețelele sociale: