Configurați interfețe separate de rețea pentru traficul DPM

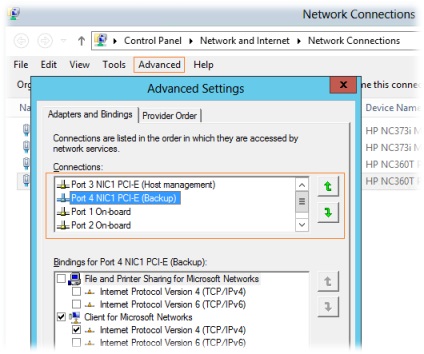

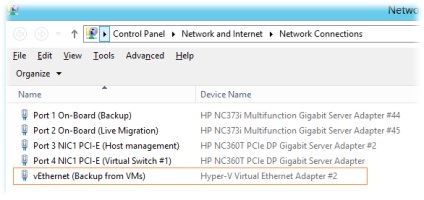

Să începem cu configurarea unei interfețe de rețea separate pe serverul DPM. Mai întâi de toate, am stabilit prioritatea utilizării interfețelor de rețea astfel încât interfața de management să fie prima.

Panoul de controlNetwork and InternetNetwork Connections> Advanced

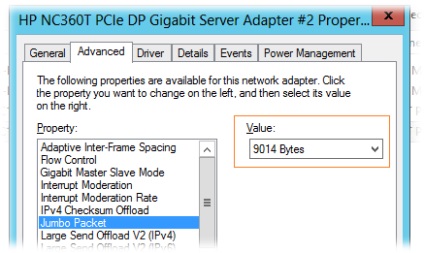

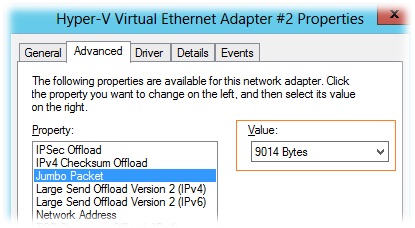

În proprietățile interfeței de rețea atribuite segmentului de rețea DPM, activați suportul Jumbo Packet la valoarea maximă posibilă

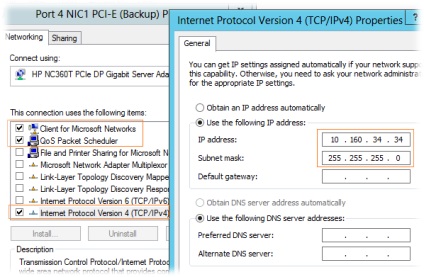

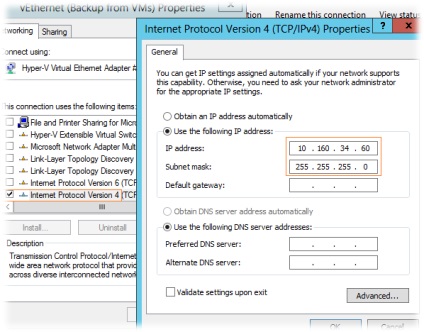

În fila Networking (Rețea) lăsăm doar numărul minim necesar de module activate:

- Client pentru rețele Microsoft

- QoS Packet Scheduler

- Protocol de Internet Versiunea 4 (TCP / IPv4)

Acum, să vorbim despre configurarea unei interfețe separate pe servere cu agentul DPM instalat. Dacă este o interfață de rețea fizică regulată este serverul configurat în același mod ca și pe serverul PDM, dacă vorbim despre gazde de virtualizare, atunci puteți merge pe mai multe scenarii diferite. Faptul este că pe gazda de virtualizare, traficul DPM poate avea loc nu numai atunci când mașinile virtuale de rezervă, dar și atunci când backup-urile de la agenții DPM sunt instalate în interiorul acestor mașini virtuale. În cazul în care primul tip de trafic pe gazda, putem lua pe o singură interfață fizică, al doilea tip de trafic avem, chiar și în prezența PDM interfață de rețea separată va cădea în interfața virtuală Hyper-V a comutatorului. Pentru a „ucide două păsări cu o piatră“ și să fie de trafic cinstit separat PDM, puteți crea o interfață de rețea gazdă separată comutator virtuale suplimentare, făcându-l disponibil sistemul de operare de management și a apărut deja adaptor virtuale utilizate pentru conectarea la un rețele de segment PDM ca de la gazdă și din interior (prin conectarea unui adaptor suplimentar de rețea virtuală la un comutator virtual realizat pentru DPM).

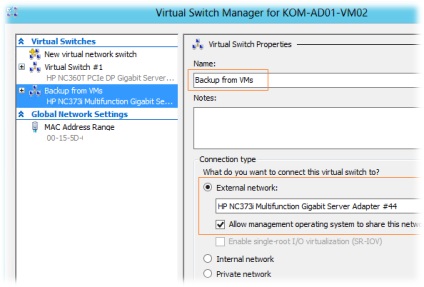

Prin urmare, agentul de virtualizare server de instalat într-o clipă PDM Hyper-V Manager va crea comutator virtuale suplimentare pe o interfață de rețea și de a permite disponibilitatea sistemului de operare gazdă virtuală de control comutator - permite sistemului de operare de management pentru a partaja acest adaptor de rețea

După salvarea setărilor pentru gazda de virtualizare, va apărea adaptorul de rețea virtuală corespunzător

În butonul Avansat deschidem setările IPv4 avansate și dezactivăm înregistrarea în DNS, precum și în proprietățile adaptorului virtual, permitem pachetul Jumbo

Deoarece am configurat utilizarea pachetelor Jumbo mari pe interfețele de rețea, trebuie să ne asigurăm că astfel de pachete pot merge între servere din segmentul de rețea DPM. Pentru a face acest lucru, puteți folosi, de exemplu, comanda Ping pentru a seta flagul de interzicere a fragmentării pachetelor și pentru a seta pachetul la o anumită valoare:

În cazul în care Ping nu merge, și vom primi un mesaj care indică faptul că fragmentarea pachet necesară, înseamnă că echipamentele noastre de rețea la care gazdele sunt conectate este limitată de mărimea pachetului și de pe acest echipament, de asemenea, trebuie să includă suport pentru pachete Jumbo. Cum se face acest lucru, de exemplu, pe un switch Cisco pe care l-am scris într-o notă anterioară.

Performanța interfeței de rețea DPM

În plus față de faptul că pentru interfețele de rețea dedicate traficului de DPM am folosit suportul Jumbo Packet. există câteva lucruri pe care le puteți acorda atenție în ceea ce privește creșterea productivității.

În unele surse, puteți îndeplini recomandarea de dezactivare a tehnologiei TCP Chimney. Pentru a afla starea actuală a acestei funcționalități, folosiți comanda:

netsh int tcp arată global

Aveți posibilitatea să dezactivați TCP Chimney cu comanda:

netsh int tcp setul cosului global = dezactivat

În plus, puteți să îndepliniți recomandarea de a dezactiva funcțiile de economisire a energiei hardware și de a face ca serverul să funcționeze în modul de înaltă performanță. În special, dezactivați utilizarea C-State în BIOS pentru procesoare. care (în unele cazuri) pot afecta pozitiv performanțele interfețelor de rețea

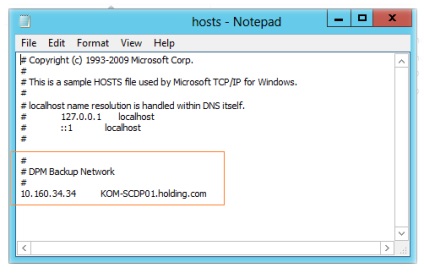

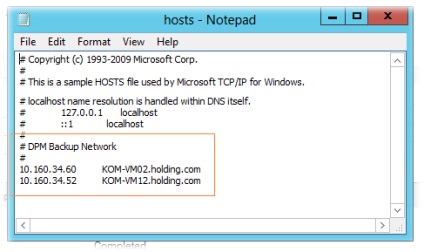

Determinați cu rezoluția numelor

Pe serverul DPM, în fișierul hosts, adăugați intrările pentru toate serverele cu agentul DPM instalat:

Limitați serverul DPM la o subrețea dedicată

Pentru a forța serverul PDM de a lucra cu agenți numai la un anumit cmdlet PowerShell utilizare subrețea pentru PDM (în PDM Administrator Console GUI, face această ajustare nu este posibilă). În cadrul Shell Management DPM realizăm:

Adăugați-DPMBackupNetworkAddress -DpmServername KOM-SCDP01 -Address 10.160.34.0 / 24 -SequenceNumber 1

Dacă doriți să rulați cmdlet-urile DPM, de exemplu, în consola ISE Windows PowerShell. - trebuie să încărcați mai întâi modulul corespunzător:

Parametrul SequenceNumber specifică prioritatea utilizării subrețelelor. Așadar, ca subrețea primară, puteți specifica o subrețea dedicată strict sarcinilor DPM și o comandă suplimentară dacă doriți să adăugați o altă subrețea (de exemplu, o rețea de control gazdă):

Adăugați-DPMBackupNetworkAddress -DpmServername KOM-SCDP01 -Address 10.160.100.0 / 24 -SequenceNumber 2

Puteți verifica setările actuale de restricționare a subrețelelor după cum urmează:

Obțineți-DPMBackupNetworkAddress -DpmServername KOM-SCDP01 | ft-autosize

După ce toate setările au fost făcute atât pe server, cât și pe agenții DPM, este de dorit să reporniți serviciul agent DPM (DPMRA) pe toate aceste sisteme.

net stop dpmra net start dpmra

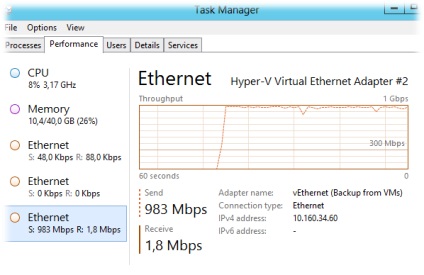

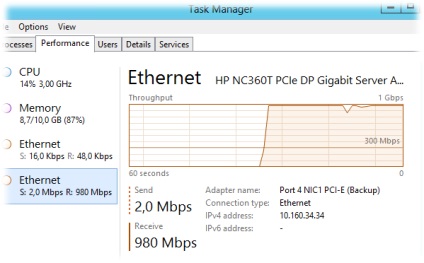

Acum puteți executa sarcina de backup pe serverul DPM și puteți verifica activitatea rețelei pe interfețele de rețea dedicate:

Pe partea de expediere, adică pe serverul protejat cu agentul DPM instalat:

În cele din urmă, am efectuat cu succes sarcini de backup, cu tot traficul de DPM care trece prin segmentul de rețea dedicat.

Surse suplimentare de informații: