Pentru a afla câte pagini au fost indexate de Google, puteți utiliza Consola de căutare. Dar cum găsiți acele adrese URL care nu se află în indexul motorului de căutare? Pentru a face față acestei sarcini, veți ajuta la crearea unui script special în Python.

Căutarea organică include trei componente principale: scanare, indexare și clasare. Când crawlerul vizitează site-ul, acesta accesează cu crawlere toate legăturile găsite. Aceste informații sunt apoi transmise indexului motorului de căutare și apoi este determinată ordinea afișării acestuia în rezultatele căutării.

Specialiștii SEO se concentrează pe componenta de clasament. Dar dacă motorul de căutare nu a putut accesa cu crawlere și indexa paginile de pe site, acesta nu va primi trafic de la Google. Asigurarea scanării și indexării corespunzătoare a site-ului reprezintă o parte importantă a optimizării motorului de căutare.

Cum să aflați câte pagini sunt indexate

Dacă aveți acces la Consola de căutare Google, puteți vedea câte pagini sunt cuprinse în Sitemap XML și câte dintre acestea au fost indexate. În același timp, serviciul nu specifică care adrese URL nu au fost incluse în indexul motorului de căutare.

Pentru a obține aceste informații, va trebui să verificați manual fiecare adresă URL. Dar această sarcină poate fi automatizată.

Cum să verificați dacă adresa URL a fost indexată de Google

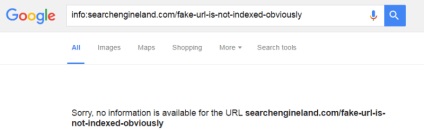

Pentru a afla dacă o anumită adresă URL a fost indexată de Google, puteți utiliza "info:" pentru operatorul de căutare. De exemplu:

Dacă adresa URL este indexată, rezultatul este:

În caz contrar, Google va returna o eroare:

Cum se utilizează Python pentru a verifica în bloc starea de indexare a paginilor

Acum știi cum să testezi o singură adresă URL. Dar cum să efectuați un control de masă? Utilizați următorul script Python:

Pentru a utiliza acest script, trebuie să instalați Python 3 pe computer. De asemenea, va trebui să instalați biblioteca BeautifulSoup. Pentru aceasta, deschideți un prompt de comandă și executați următoarea comandă:

pip instalați beautifulsoup4

După aceasta, puteți descărca scriptul pe computer. În același folder în care este localizat scriptul, creați un fișier text cu o listă de adrese URL. Fiecare adresă URL trebuie să fie un șir separat.

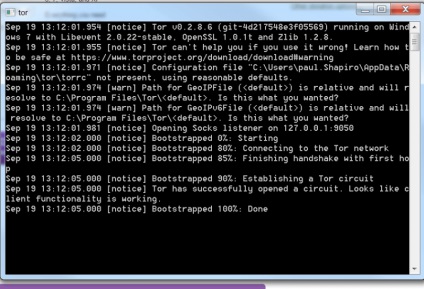

Acum, că scriptul este gata să funcționeze, trebuie să instalați și să configurați Tor pentru al utiliza ca server proxy. Pe Windows, descărcați Tor Expert Bundle. Extrageți directorul din arhivă în directorul local de pe PC și rulați tor.exe. Fereastra poate fi minimizată.

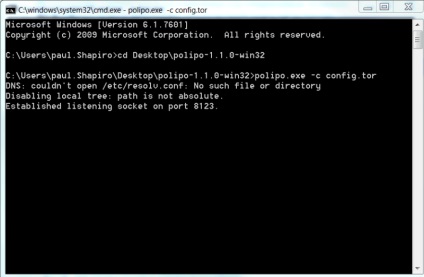

Deschideți un prompt de comandă și accesați folderul Polipo. Eliberați următoarea comandă:

polipo.exe -c config.txt

În acest moment, puteți rula scriptul Python:

Scriptul vă va cere să specificați numărul de secunde de așteptat între verificări pentru fiecare adresă URL.

Apoi vă va cere să introduceți un nume de fișier (fără o extensie) pentru a încărca rezultatele în CSV.

În cele din urmă, acesta va cere numele fișierului text care conține lista de adrese URL de verificat.

Introduceți aceste date și executați scriptul.

Rezultatul final va fi prezentat ca fișier CSV, care poate fi ușor deschis în Excel.

În tabelul rezultat, adresa URL indexată va fi setată la TRUE, iar adresa URL neindexată va fi setată la FALSE.

Dacă scriptul nu funcționează, Google poate să blocheze Tor. În acest caz, utilizați propriul server proxy modificând următoarele linii ale scriptului:

concluzie

Știind ce pagini au fost indexate de Google este extrem de important pentru SEO. Nu veți putea obține trafic de la căutare dacă paginile dvs. nu se află în indexul motorului de căutare.

Din păcate, Google nu oferă informații despre ce adrese URL nu au fost indexate. Dar această problemă este rezolvată. Folosind scriptul descris mai sus, puteți obține aceste date fără mari dificultăți.