În acest articol

În acest articol vă va învăța cum să setați notebook-Jupyter cu nuclee personalizate PySpark (pentru Python) și Spark (pentru Scala), prin comanda magică Spark, și apoi conectați notebook-ul la un HDInsight cluster. Există motive diferite pentru instalarea lui Jupyter pe computerul local, dar există unele dificultăți. Pentru mai multe informații, consultați De ce să instalați Jupyter pe un computer? la sfârșitul acestui articol.

Pentru a instala Jupyter și comanda magic Spark pe computerul dvs., trebuie să efectuați trei pași de bază.

- Instalarea notebook-ului Jupiter

- Instalați kernelul PySpark și Spark cu comanda magic Spark

- Configurați comanda magică a Spark pentru a accesa clusterul Spark în HDInsight

Pentru mai multe informații despre kernel personalizate și comenzi magice Spark, disponibile pentru notebook-uri Jupyter HDInsight dintr-un cluster, a se vedea. Kernel Articolul disponibile pentru notebook-uri Jupyter Spark în Apache grupate HDInsight pe platforma Linux.

Cerințe preliminare

Condițiile prealabile enumerate aici nu se aplică instalării Jupyter. Acestea se referă la conectarea notebook-ului Jupyter la clusterul HDInsight după instalarea notebook-ului.

Instalarea notebook-ului Jupyter pe computer

Înainte de a instala notebook-uri Jupyter, trebuie să instalați Python. Python și Jupyter sunt disponibile ca parte a distribuției Anaconda. Instalarea programului Anaconda instalează distribuția Python. După instalarea programului Anaconda, executați comenzile corespunzătoare pentru a instala Jupyter.

- Descărcați programul de instalare Anaconda pentru platforma dvs. și rulați programul de instalare. În Expertul de configurare, specificați opțiunea de a adăuga Anaconda la variabila PATH.

Rulați următoarea comandă pentru a instala Jupyter.

Pentru mai multe informații despre instalarea Jupyter, consultați aici.

Instalarea nucleelor și a echipei magice Spark

Instrucțiunile pentru instalarea echipei magice Spark, precum și a kernel-urilor PySpark și Spark, consultați documentația pentru sparkmagic pe site-ul GitHub. Pentru a începe să utilizați comanda magic Spark, trebuie să o instalați mai întâi. Acesta este primul pas descris în documentație. Înlocuiți acest pas în legătura de mai sus cu următoarele comenzi, luând în considerare versiunea clusterului HDInsight la care vă conectați. După aceea, urmați pașii rămași în conformitate cu documentația pentru echipa magică Spark. Pentru a instala diferite miezuri, trebuie să efectuați pasul 3 din secțiunea cu instrucțiuni pentru instalarea comenzii magic Spark.

Pentru clustere de versiunea 3.4, instalați versiunea sparkmagic 0.2.3 executând comanda pip install sparkmagic == 0.2.3

Pentru clusterele de la versiunile 3.5 și 3.6, instalați versiunea sparkmagic 0.11.2 executând comanda pip install sparkmagic == 0.11.2

Configurarea comenzii magice a Spark pentru conectarea la clusterul HDInsight Spark

În această secțiune, veți configura conexiunea comenzii magice Spark, instalată mai devreme, în clusterul Apache Spark, pe care l-ați creat deja în Azure HDInsight.

Informațiile de configurare Jupyter sunt de obicei stocate în directorul de domiciliu al utilizatorului. Pentru a găsi directorul de acasă, introduceți următoarele comenzi (acestea sunt potrivite pentru orice platformă OS).

Porniți shell-ul Python. În linia de comandă, tastați următoarea comandă:

În shell-ul Python, tastați următoarea comandă pentru a găsi directorul de acasă.

Accesați directorul de acasă și creați un folder numit .sparkmagic. dacă nu există deja.

În acest dosar, creați fișierul config.json și adăugați următoarea bucată de cod JSON la acesta.

Înlocuiți-l. și valorile corespunzătoare. Pentru a crea o parolă în codarea base64, puteți utiliza diferite utilitare în limba de programare preferată sau pe instrumentele disponibile pe Internet.

Corectați setările ritmului cardiac în config.json. Acești parametri trebuie adăugați la același nivel cu fragmentele kernel_python_credentials și kernel_scala_credentials. care au fost adăugate mai devreme. În acest exemplu, fișierul config.json arată cum și unde sunt adăugate setările ritmului cardiac.

Pentru sparkmagic 0.2.3 (cluster-ul versiunea 3.4), adăugați:

Pentru sparkmagic 0.11.2 (clustere de la versiunile 3.5 și 3.6) se adaugă:

Heartbeats sunt trimise pentru a preveni scurgeri de sesiuni. Când intrați în modul de hibernare sau opriți calculatorul, nu este trimis niciun impuls, ceea ce va șterge sesiunea. Dacă doriți să dezactivați acest comportament pentru cluster-ele versiunea 3.4, puteți seta parametrul Livy livy.server.interactive.heartbeat.timeout la 0 utilizând interfața de utilizator Ambari. Dacă pentru grupurile din versiunea 3.5 nu configurați configurația corespunzătoare de mai sus, atunci sesiunea nu va fi ștearsă.

Porniți Jupiter. Rulați următoarea comandă din linia de comandă.

Asigurați-vă că vă puteți conecta la cluster folosind notebook-ul Jupyter și utilizați comanda magic Spark cu nucleele. Faceți următoarele:

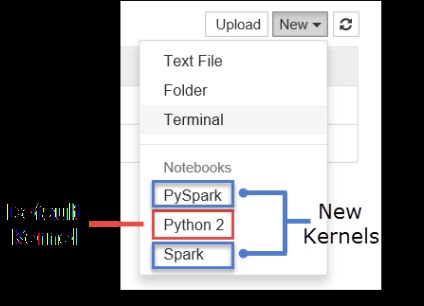

a. Creați un nou notebook. În colțul din dreapta sus, faceți clic pe Nou. Ar trebui să vedeți kernelul implicit Python2 și cele două kernel-uri noi pe care le-ați instalat: PySpark și Spark. Faceți clic pe PySpark.

b. Rulați următorul fragment de cod.

Dacă ați primit de ieșire, conexiunea la clusterul HDInsight funcționează.

Dacă doriți să actualizați configurația notebook-ului pentru a vă conecta la alt cluster, schimbați fișierul config.json cu un nou set de valori, așa cum se arată în pasul 3.

De ce să instalați Jupiter pe computerul meu?

Există mai multe motive pentru care trebuie să instalați Jupyter pe computer și să îl conectați la clusterul Spark în HDInsight.

- Deși notebook-urile Jupyter sunt deja disponibile în clusterul Spark din Azure HDInsight, după instalarea lor pe computer, puteți crea notebook-uri la nivel local, puteți testa aplicațiile pe un cluster de lucru și puteți trimite notebook-uri către cluster. Pentru a trimite notebook-uri către cluster, le puteți trimite utilizând notebook-ul Jupyter care rulează pe cluster sau le puteți salva în folderul / HdiNotebooks din contul de stocare asociat clusterului. Pentru mai multe informații despre stocarea notebook-urilor într-un grup, consultați Unde sunt stocate notebook-urile.

- Cu ajutorul notebook-urilor disponibile pe plan local, vă puteți conecta la diferite clustere Spark, în funcție de nevoile aplicației dvs.

- Puteți utiliza GitHub pentru a implementa un sistem de control al versiunilor pentru a controla versiunile de notebook-uri. De asemenea, puteți crea un mediu de colaborare în care mai mulți utilizatori vor lucra cu un notebook.

- Puteți lucra cu notebook-uri la nivel local chiar și fără cluster. Clusterul este necesar numai pentru testarea notebook-urilor, dar nu este necesar pentru gestionarea manuală a notebook-urilor sau a mediului de dezvoltare.

- Poate fi mai ușor să configurați un mediu de dezvoltare locală decât să configurați instalarea Jupyter într-un cluster. Puteți utiliza în siguranță orice software instalat local fără a configura clustere de la distanță.

Dacă Jupyter este instalat pe computerul local, mai mulți utilizatori pot porni simultan același notebook în același cluster Spark. În această situație, sunt create mai multe sesiuni Livy. Dacă întâmpinați probleme și începeți să le depanați, va fi dificil pentru dumneavoastră să determinați ce sesiune Livy aparține utilizatorului.