Ce înseamnă voie în robots.txt?

Disallow este una dintre principalele directive care fac roboți fișier txt.

Roboții txt interziceți utilizate întotdeauna în legătură cu directiva și user-agent este utilizat pentru a restricționa accesul la paginile site-ului.

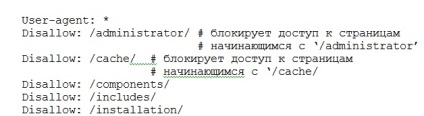

Disallow în roboți txt pot fi de mai multe. De fapt, numărul acestor directive este limitată doar de dimensiunea fișierului robots.txt (Figura 1).

Figura 1. Numărul interziceți în fișierul robots.txt este limitată doar de dimensiunea

interziceți directivă se aplică pentru fiecare robot de separat. Numele robotului este specificat în Directiva user-agent.

În cazul în care user-agent în loc de un nume este în valoare de un asterisc (*), apoi aplicat pentru a dezafecta roboți de la vizitarea site-ului.

Cum să se înregistreze Disallow

După interziceți directive rodots txt întotdeauna două puncte (:), și apoi parametrii, setați calea de pe site-ul

Lipsa de opțiuni din directiva Disallow presupune accesul deplin la toate paginile site-ului, de exemplu:

User-agent: * # * parametru indică faptul că directiva

# Disallow se aplică tuturor roboți

Disallow: # Accesul este deschis la toate paginile

Parametru slash înainte (/) pentru a nu permite roboți txt să blocheze accesul la toate paginile site-ului. Desigur, în cazul în care este utilizat singur, de exemplu:

Disallow: / # Acces oprit pentru toate paginile site-ului

Pentru a reduce numărul de directive interziceți robots.txt. puteți aplica așa-numitele expresii regulate. Linia de jos este că, ca un parametru pentru a nu permite acasă directorul specificat și apoi utilizați un asterisc caracter special (*). Simbolul * înseamnă orice secvență de caractere, inclusiv goale. De exemplu:

Disallow: / administrator / * # blocarea accesului la pagini incepand cu

# „/ Administrator“ și apoi orice caracter

Disallow: / * / cache # bloca accesul la paginile care conțin calea

În mod implicit, caracterul * este atribuit la sfârșitul fiecărei reguli în directiva Disallow.

Asta este, chiar dacă nu pune la sfârșitul caracterului *, se crede că este acolo. Trebuie amintit.

Această regulă poate fi anulată prin aplicarea pentru a nu permite roboți txt directivă la sfârșitul unui alt caracter special - un semn dolar ($). Aceasta anulează regula implicită - * la capătul drumului. De exemplu:

Disallow: / componentă # închide accesul la paginile, incepand cu

# 'Component', de exemplu, 'componentă'; / 'component.html' etc.

Disallow: / componentă $ # interzice calea de „componentă“, dar nu se închide

# Accesați pagina „component.html“ și altele.

Astfel, crearea unei anumite expresii regulate folosind caracterele speciale „*“ și „$“, este posibil să se închidă accesul atât la directoare întregi precum și la o pagină separată. Acest lucru reduce semnificativ timpul pentru a crea un fișier robots.txt și reduce volumul său. Faptul este că fișierul robots.txt este limitat de volum.

Roboții txt directivă împiedică în mod fiabil interzic în accesul la anumite pagini ale site-ului. Prin urmare, crearea unui fișier, trebuie să verificați rezultatul acțiunilor sale.

Pentru a face acest lucru, în primul rând, verificați fișierul în sine, și apoi urmăriți indexarea paginilor înainte și după aplicarea directivei disallowrobotstxt. Apropo, fișierul robots.txt în directorul rădăcină al site-ului.

P.S. Robots.txt fișier interziceți dirrektiva un universal pentru toate tipurile de CMS - sisteme. Fie că este vorba joomla, wordpress sau orice alt sistem de management al conținutului.